Vous avez entendu parler des RAG (Retrieval-Augmented Generation) mais vous ne savez pas par où commencer ?

Entre la multitude de méthodes disponibles et les enjeux techniques, il peut être difficile de s’y retrouver. C’est justement pour faciliter cette exploration que nous avons développé OpenRAG : un outil open source qui simplifie la comparaison des principales approches RAG tout en rendant cette technologie plus accessible, plus transparente, et plus éthique.

Nous invitons nos lecteurs peu familiers avec la technologie RAG à lire a minima le premier article de notre série sur les RAGs afin d’assurer une bonne compréhension de cet article.

Quelles opportunités offertes par les RAG ?

Les perspectives ouvertes par les RAG sont nombreuses. À tel point qu’elles entraînent une frénésie d’innovation, difficile à suivre et à évaluer.

Quelle entreprise en effet n’a jamais souhaité améliorer l’accès à l’information pour ses collaborateurs ? Les données sont difficilement accessibles et ne sont pas exploitées à leur plein potentiel.

Résultat, cela peut entraîner une perte de temps considérable, une diminution de l’efficacité opérationnelle et des prises de décision moins éclairées. En parallèle, le manque de partage de la connaissance engendre une duplication des efforts et une frustration générale au sein des équipes.

Améliorer l’accès à l’information n’est pas seulement une question de commodité, mais un impératif stratégique pour optimiser le fonctionnement de l’entreprise et favoriser une culture collaborative en interne.

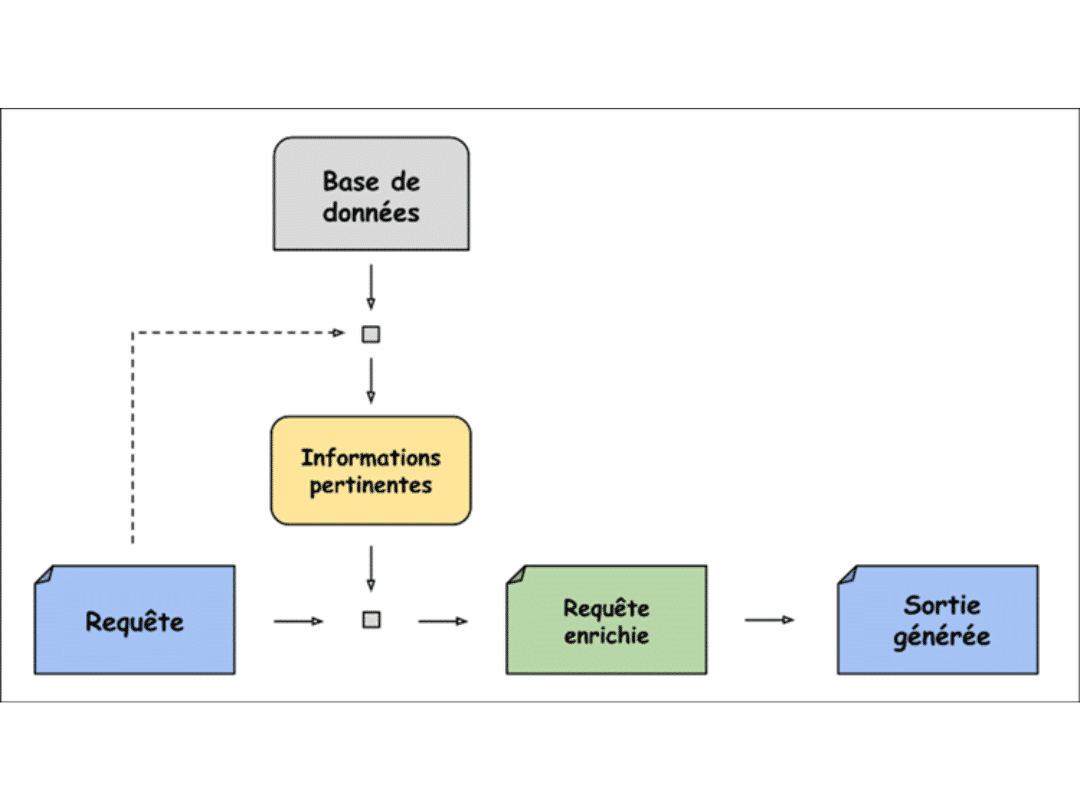

Dans ce contexte, la méthode RAG (Retrieval Augmented Generation) offre des perspectives prometteuses pour répondre à ce besoin. Elle permet aux entreprises de connecter leur base de connaissances à un LLM (Large Language Model) et de l’interroger directement.

Après chaque requête, effectuée en langage naturel, la base de connaissances est parcourue en vue de déterminer les informations les plus pertinentes pour répondre au besoin. Une fois les informations récupérées, elles sont transmises au LLM qui pourra, à l’aide du contexte qui lui a été fourni, produire une réponse enrichie par les connaissances de l’entreprise.

Les avantages du RAG

Cette technologie permet de mettre à disposition des collaborateurs des agents personnalisés pour améliorer leur qualité de vie et réduire le temps perdu dans l’exécution de tâches à faible valeur ajoutée. Par exemple : parcourir une base documentaire.

Une diversité de RAG

Devant de tels enjeux, la recherche et l’innovation liées aux RAG sont extrêmement dynamiques. En effet, plusieurs méthodes de RAG voient le jour chaque semaine. Elles permettent d’adresser des cas d’usage différents : certaines sont plus appropriées pour un type de données tandis que d’autres complètent et vérifient les informations transmises grâce à une recherche internet.

Il en existe aujourd’hui des centaines. Cette diversité est prometteuse et entraîne un gain des performances globales de la technologie mais aussi une augmentation de la puissance de calcul nécessaire à son fonctionnement.

En raison d’une telle prolifération, les entreprises se trouvent face à une multitude de choix :

- Identifier la méthode adaptée à ses besoins parmi les nombreuses existantes ;

- Évaluer les ressources humaines, techniques et financières nécessaires ;

- Implémenter, puis personnaliser cette méthode ;

- Arbitrer entre performances, coûts et contraintes écologiques.

Le coût du RAG

Le ticket d’entrée, ne serait-ce que pour tester une telle technologie, est pour beaucoup trop conséquent : les ressources humaines, organisationnelles et financières demandées sont trop grandes face au manque de visibilité sur les résultats d’une telle opération.

Les défis associés à ce processus deviennent souvent un obstacle à l’adoption. C’est pourquoi nous avons cherché à les atténuer en simplifiant la prise en main de la technologie RAG.

OpenRAG by Meritis : comment ça marche ?

Pourquoi OpenRag by Meritis ? Pour tester les performances et les coûts des principales méthodes de RAG grâce à un outil open source.

Au sein de la cellule Innovation de Meritis, nous avons mis au point un outil de benchmark de RAG. Cet outil a pour but d’accompagner un utilisateur dans sa réflexion autour des différentes méthodes en lui donnant la possibilité de les utiliser et de les évaluer sans avoir à implémenter chacune d’entre elles.

Objectif : lui permettre de télécharger notre application et de l’utiliser au choix, sur son propre hardware, sur une machine virtuelle ou via une clé API, OpenAI ou Mistral par exemple.

Une fois l’installation réalisée, l’utilisateur peut :

- Uploader sa propre base de connaissances ;

- Interagir avec une vingtaine de RAG préconfigurés ;

- Juger de la pertinence des réponses fournies ;

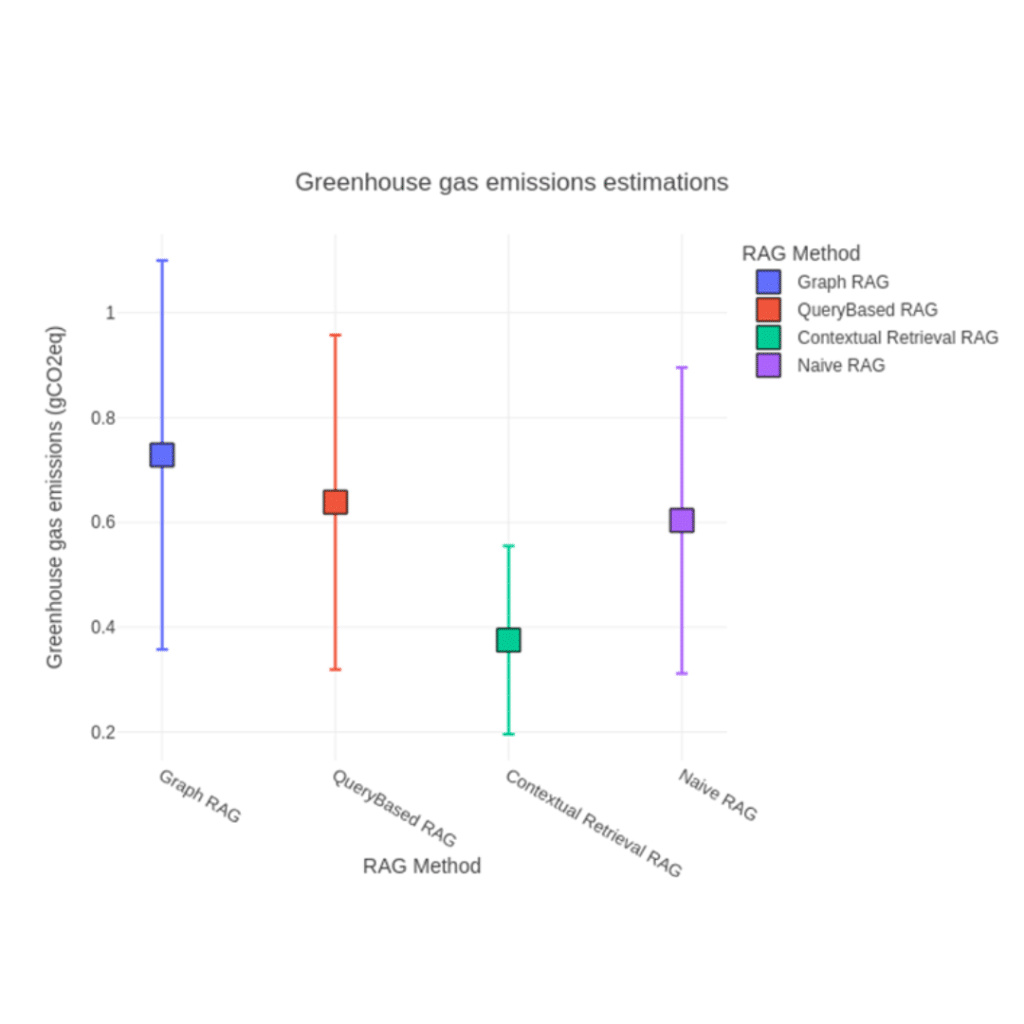

- Contrôler la consommation de tokens, le temps de réponse et l’impact écologique de sa demande via le tracker EcoLogits ;

Intervalle d’émission pour chaque méthode de RAG

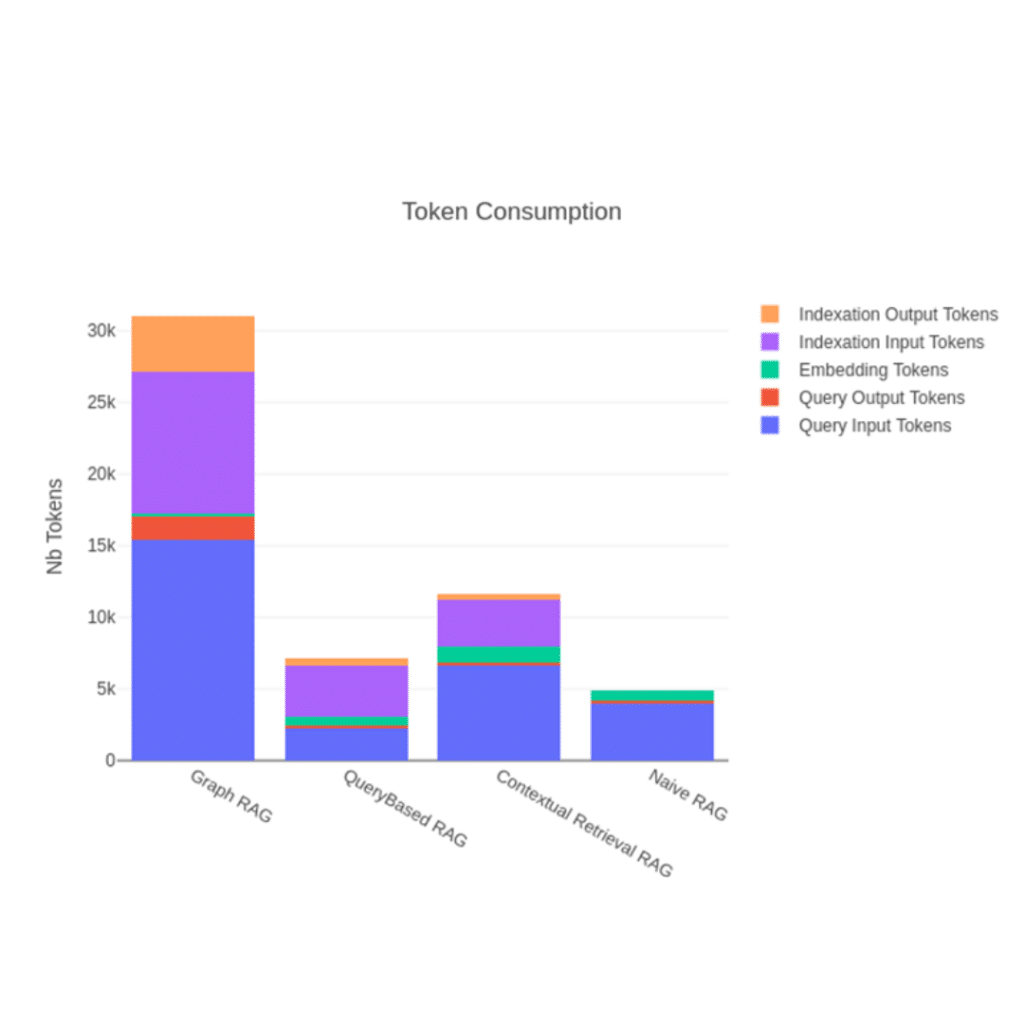

Pour obtenir une étude plus approfondie des performances de chaque RAG, l’utilisateur peut fournir une liste de questions spécifiques à ses données ainsi que les réponses attendues à l’outil de benchmark.

Celui-ci lui fournira alors des résultats quantitatifs sur les RAG sélectionnés afin de mesurer la qualité du contexte extrait, des réponses données ainsi que le nombre de tokens consommés.

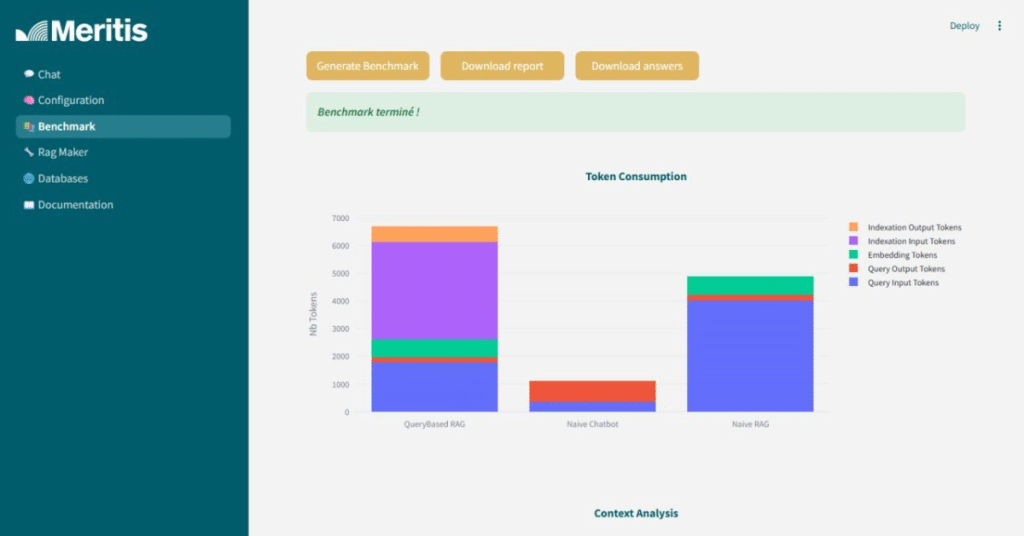

Exemple de résultats produits lors d’un benchmark

L’évaluation “LLM as a Judge”

L’évaluation permet de comparer différentes méthodes de RAG en s’appuyant sur des métriques conçues pour analyser à la fois la qualité du contexte extrait et la pertinence des réponses générées.

Ces métriques reposent sur le principe du “LLM as a Judge”, c’est-à-dire qu’un modèle de langage est utilisé pour évaluer les réponses. Ce modèle est soigneusement prompté afin de suivre un raisonnement prédéfini et attribuer un score à chaque réponse.

Bien que cette approche offre des métriques quantitatives sur des aspects sémantiques complexes, elle repose sur un modèle qui, comme tout système d’IA, reste faillible. Il est donc essentiel que l’utilisateur conserve un esprit critique face aux résultats, car l’intelligence artificielle a ses limites.

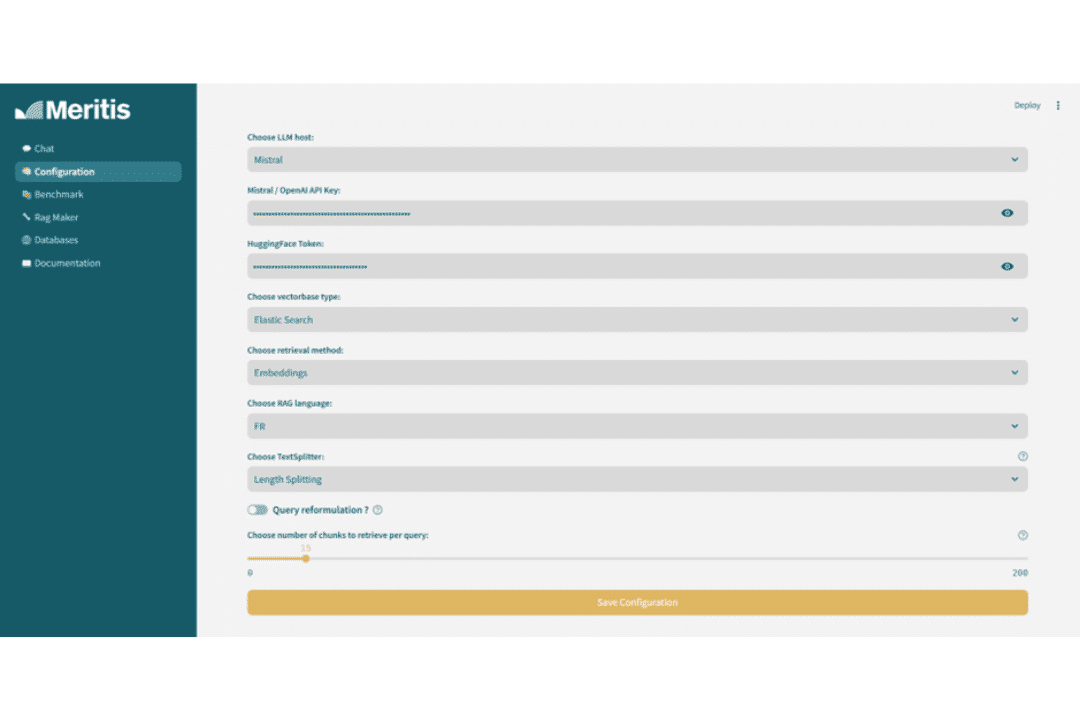

Adapter chaque RAG à votre cas d’usage

Chaque méthode RAG implémentée peut être personnalisée : choix de l’algorithme de récupération, base vectorielle, découpage du texte, etc. Une fois la méthode la plus prometteuse identifiée, l’utilisateur peut affiner davantage les réglages pour optimiser les performances ou réduire les coûts.

Outil de personnalisation de RAG

L’outil étant entièrement open source, les utilisateurs peuvent :

- Consulter la documentation technique pour comprendre les traitements appliqués aux données, les logiques internes des méthodes RAG et les métriques utilisées ;

- Remplacer les modèles LLM par défaut (Gemma 2-9B de Google, 4o-mini d’OpenAI, ou Mistral Small selon le fournisseur) par d’autres modèles s’ils le souhaitent ;

- Modifier le code à leur guise pour : ajouter des méthodes de RAG, modifier les métriques d’évaluation…

Une expertise partagée avec la communauté

Avec OpenRAG, Meritis met à disposition de la communauté open source le fruit d’une année complète de recherche sur les RAG. Objectif : démocratiser cette technologie et faciliter son adoption dans les entreprises, quels que soient leurs moyens. Si vous souhaitez tester l’outil, rendez-vous sur la page Github dédiée

Une fois le code de l’application téléchargé et ouvert dans votre éditeur de code, placez-vous dans le dossier open_rag et lancez les commandes suivantes dans votre terminal pour installer tous les éléments nécessaires au fonctionnement de l’application :

– Cd docker (se place dans le répertoire docker)

– Sudo docker compose –f [NOM DU DOCKER] up –d

- Docker-compose-all.yml : lance tous les services (Elastic Search, le frontend, Ollama et VLLM) ;

- Docker-compose-api.yml : lance Elastic Search et le frontend, seuls OpenAI et Mistral seront utilisables ;

- Docker-compose-ollama.yml : lance uniquement Elastic Search, le frontend et ollama, nécessite un GPU ;

- Docker-compose-vllm.yml : lance Elastic Search, le frontend et VLLM, nécessite un GPU.

Pour choisir quel docker lancer, vous devez décider de la méthode de LLM que vous souhaitez utiliser pour votre utilisation de l’application (OpenAI, Mistal AI, Ollama ou VLLM).

Une fois l’installation des dockers terminée dans votre moteur de recherche – cela peut prendre quelques minutes –, rentrez l’URL suivante : http://localhost:8506/

Pour en savoir plus ou bénéficier d’un accompagnement personnalisé dans vos projets IA, contactez la cellule innovation : la cellule Innovation.

Conclusion

Avec OpenRAG, Meritis franchit une nouvelle étape dans sa mission d’innovation responsable. En rendant le benchmark des méthodes RAG simple, accessible et mesurable, nous permettons à chacun — PME, grands groupes, experts ou curieux — d’expérimenter cette technologie prometteuse en toute autonomie. L’avenir des RAG s’écrit aujourd’hui, dessinant avec lui le futur des usages IA en entreprises. Nous sommes fiers d’y contribuer en partageant notre expertise avec la communauté.

Pas encore de commentaires