Meritis lance OpenRAG, un outil open source permettant de comparer les performances de plus de 20 architectures RAG (Retrieval-Augmented Generation). Objectif : aider les équipes techniques à faire des choix éclairés pour leurs projets IA générative, à partir de données concrètes, mesurables et reproductibles.

Benchmarker les RAG sur vos données, en toute transparence

Les systèmes RAG sont devenus des briques clés de l’IA générative moderne. Ils permettent aux LLM d’interroger une base documentaire externe pour produire des réponses plus précises, actualisées et contextuelles.

Mais face à la diversité des implémentations (LangChain, Haystack, LlamaIndex…), il reste difficile de choisir le bon pipeline. Jusqu’ici, aucune solution ne permettait de comparer objectivement plusieurs systèmes RAG sur des critères concrets tels que la pertinence des réponses, la consommation de tokens, le temps de traitement ou encore l’impact énergétique.

👉 C’est précisément ce que propose OpenRAG, le premier outil open source de benchmark RAG, développé par la cellule Innovation de Meritis.

Ce que permet OpenRAG

- Comparer plus de 20 pipelines RAG en conditions réelles

- Tester ses propres données métier dans deux modes complémentaires :

- Mode Chat : interagir avec un RAG sélectionné

- Mode Benchmark : tester plusieurs systèmes de façon structurée

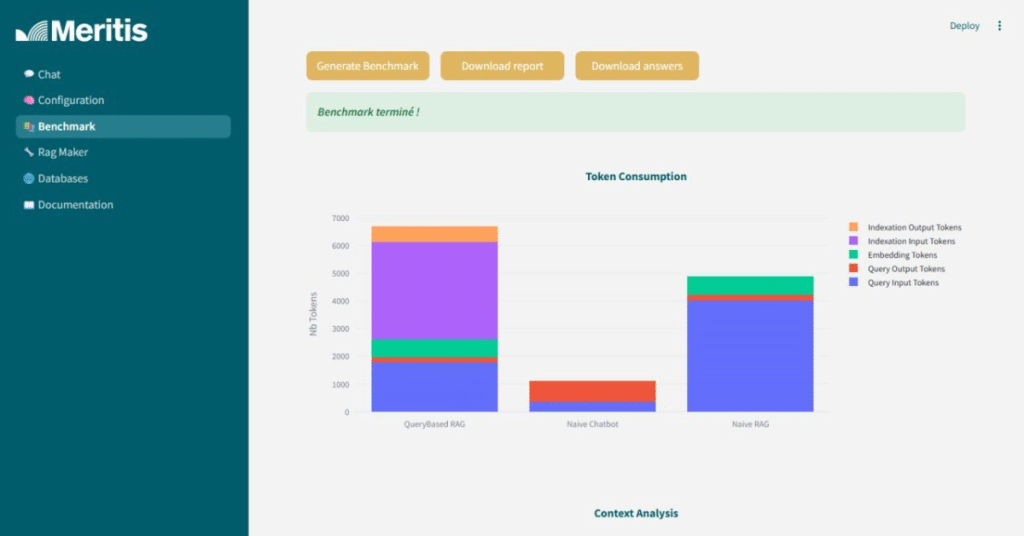

- Mesurer les performances sur des critères clés :

- qualité des réponses (scoring LLM-as-a-judge)

- tokens consommés

- temps de réponse

- estimation de l’impact carbone

- Visualiser les résultats via un dashboard interactif

- Générer des rapports exploitables pour arbitrer vos choix technologiques

L’outil est livré avec une configuration Docker/Conda, compatible avec des modèles open source (Mistral, Ollama, VLLM…) ou propriétaires (OpenAI, Anthropic). Il peut être déployé en local, sur serveur ou dans un environnement sécurisé.

Une plateforme conçue pour les équipes techniques

OpenRAG s’adresse aux professionnels directement impliqués dans la conception, l’évaluation ou l’industrialisation de pipelines RAG :

- CDO, Head of Data : arbitrer des choix technologiques à partir d’indicateurs fiables

- CTO, architectes IA : valider une architecture RAG compatible avec les exigences du SI

- Data scientists, ingénieurs IA : tester, modifier et personnaliser les approches

- Product Managers IA, Labs innovation : cadrer un POC ou enrichir un MVP avec les bons composants

OpenRAG : open source, sobre et orienté impact

Lancé sous licence MIT, OpenRAG est accessible librement sur GitHub. Il s’agit de la première contribution open source de Meritis, société de conseil en IT et Data certifiée B Corp™.

« Notre ambition avec OpenRAG est simple : fournir un socle objectif, transparent et réutilisable pour choisir un système RAG adapté à son contexte métier. C’est une brique d’utilité publique pour toutes les équipes IA générative qui veulent aller au-delà de la hype. »

— Théodore Boullier, Directeur Innovation, Meritis

L’initiative s’inscrit dans une volonté plus large : encourager une adoption responsable des technologies génératives, en fournissant des outils sobres, auditables et intégrables dans des environnements exigeants.

Lancez votre benchmark 🚀

Clonez le repo, installez-le localement ou en Docker, et testez votre stack RAG dès aujourd’hui.

📩 Vous souhaitez une démonstration, un accompagnement à l’intégration, ou un audit technique de votre pipeline IA ?

Contactez directement notre équipe Innovation ⤸.

Vous avez un projet IA en cours ou à venir ? Contactez notre équipe Innovation

Nous accompagnons les équipes techniques dans :

- l’intégration d’OpenRAG dans des environnements complexes

- l’adaptation des benchmarks à vos contraintes métier ou sécurité

- l’analyse et l’optimisation de vos choix technologiques